源码

bootstrap

Pyinstaller

skill command

html静态页面

跨境电商

数据介绍

下载视频

VMware

三星刷机

safari

tensorrt

Android 5

代码加密

代码质量

DDD领域驱动设计

scikit-learn

Dynamics365 CRM

使用笔记

量化交易

AUC

2024/4/21 2:43:212.6 如何计算AUC?

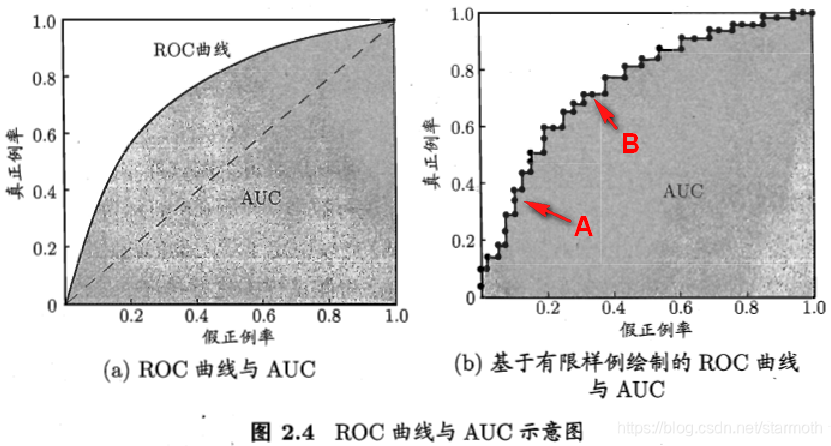

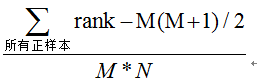

2.6 如何计算AUC? 前情提要: 2.4 ROC曲线是什么? 2.5 如何绘制ROC曲线? AUC定义:AUC指的是ROC 曲线下的面积大小,该值能够量化地反映基于ROC曲线衡量出的模型性能。

计算方法:计算AUC值只需要…

GEE ——绘制二元分类的特征 (ROC) 曲线、计算曲线下面积 (AUC)

简介:

一个示例 GEE 脚本,用于绘制二元分类的接收者操作特征 (ROC) 曲线、计算曲线下面积 (AUC) 并找到最接近完美分类的截止点。

要计算ROC曲线,首先需要计算分类器不同阈值下的真正率(TPR)和假正率(FPR)。TPR是正确分类的正例的比例,而FPR是错误分类的负例的比例。…

召回率、准确率、ROC曲线、AUC、PR曲线

1 数据集下载

THUCNews中文文本分类数据集 部分数据下载链接为https://pan.baidu.com/s/1hugrfRu 密码:qfud。完整数据下载方式为:访问 http://thuctc.thunlp.org/message, 需要提交个人信息、尊重THUNLP资源使用协议,从而获取正…

从roc曲线到auc

1.为什么我们要用roc曲线进行评价

用传统的识别率来评价模型的话会有下面的缺陷:

在类不平衡的情况下, 如正样本90个,负样本10个,直接把所有样本分类为正样本,得到识别率为90% 而如果正样本识别对75个,负样本识别对5个,得到的识别率为80%。…

统计学习基础--第四章 分类

目录

一、逻辑斯谛回归(logistic)

1、Logistic模型

(1)概率

(2)逻辑斯谛函数

(3)注意

2、估计回归系数

(1)方法:极大似然估计

࿰…

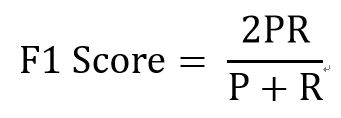

准确率(Precision)、召回率(Recall)、F值对于模型的评估

一、有哪些模型评估方法?

在机器学习、数据挖掘、推荐系统完成建模之后,需要对模型的效果做评价。

业内目前常常采用的评价指标有准确率(Precision)、召回率(Recall)、F值(F-Measure)等,下图是不同机器学习算法的评价指标。下文讲对其中某些…

【机器学习基础】机器学习的模型评估(评估方法及性能度量原理及主要公式)

🚀个人主页:为梦而生~ 关注我一起学习吧! 💡专栏:机器学习 欢迎订阅!后面的内容会越来越有意思~ 💡往期推荐: 【机器学习基础】机器学习入门(1) 【机器学习基…

一文彻底搞懂ROC曲线与AUC的概念

一文彻底搞懂ROC曲线与AUC的概念1. ROC曲线的初级含义1.1 精确率和召回率1.2 ROC曲线的含义2. ROC曲线如何绘制3. ROC曲线和排序有什么关联?4. AUC和基尼系数有什么纠葛?1. ROC曲线的初级含义

要了解ROC的含义,必须先搞懂混淆矩阵的含义&…

python3 如何评价模型的表现(分类指标:confusion matrix、ROC、AUC)

1. 错误率和准确率

准确率不是评价模型好坏的标准,如遇到类别不平衡(class imbalance)的数据,典型的垃圾邮件问题,99%的邮件都是非垃圾邮件,1%为垃圾邮件,那分类准确率99%就没有什么意义。

错…