DSConv卷积模块

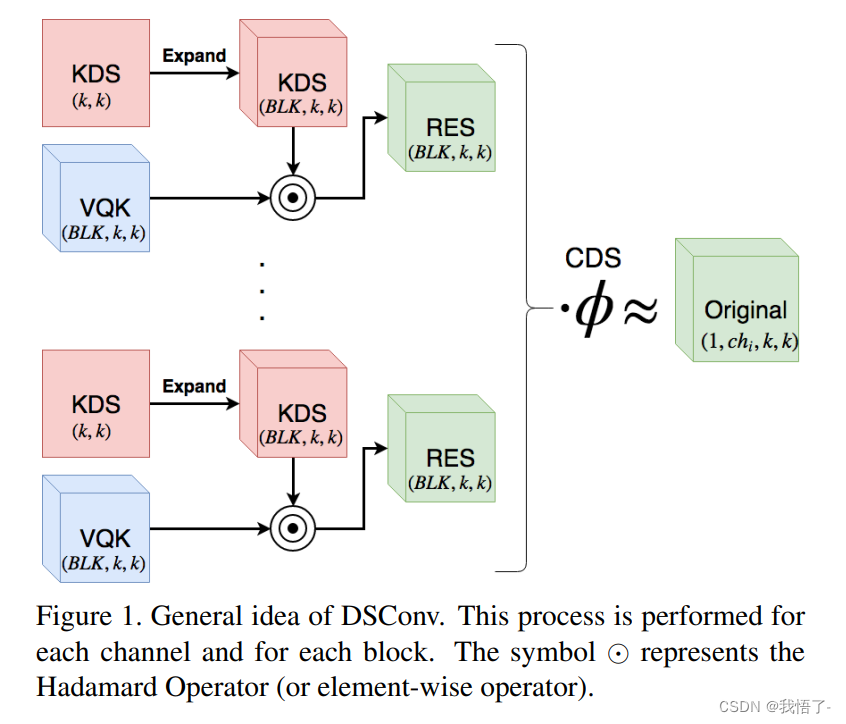

DSConv(分布偏移卷积)可以容易地替换进标准神经网络体系结构并且实现较低的存储器使用和较高的计算速度。 DSConv将传统的卷积内核分解为两个组件:可变量化内核(VQK)和分布偏移。 通过在VQK中仅存储整数值来实现较低的存储器使用和较高的速度,同时通过应用基于内核和基于通道的分布偏移来保持与原始卷积相同的输出。 我们在ResNet50和34以及AlexNet和MobileNet上对ImageNet数据集测试了DSConv。 我们通过将浮点运算替换为整数运算,在卷积内核中实现了高达14x的内存使用量减少,并将运算速度提高了10倍。 此外,与其他量化方法不同,我们的工作允许对新任务和数据集进行一定程度的再训练。

原文地址:DSConv: Efficient Convolution Operator

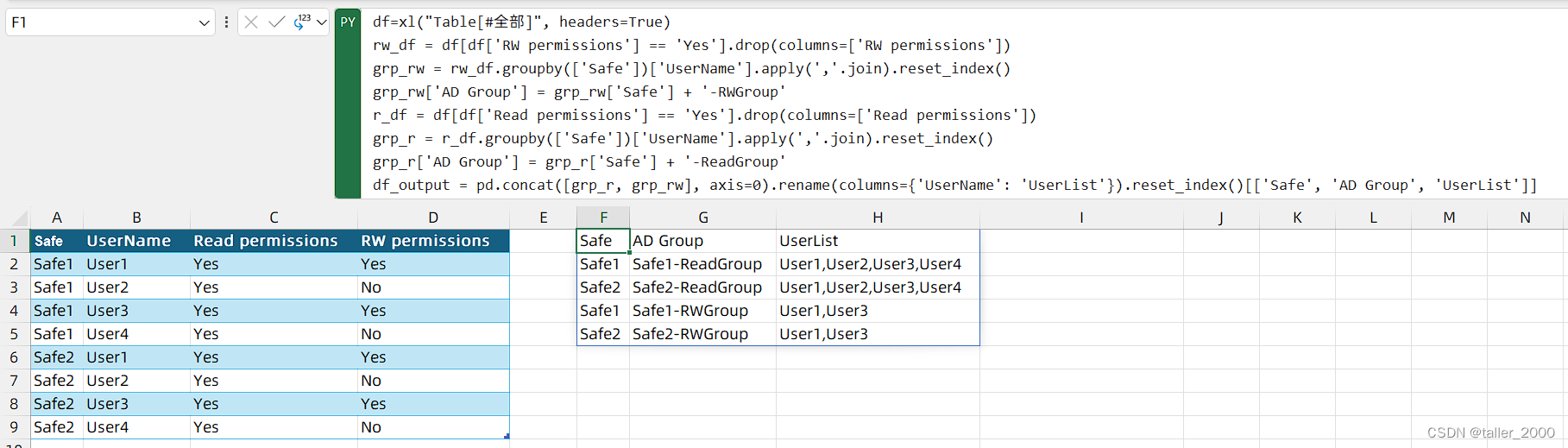

代码实现:

import torch.nn.functional as F

from torch.nn.modules.conv import _ConvNd

from torch.nn.modules.utils import _pair

class DSConv(_ConvNd):

def __init__(self, in_channels, out_channels, kernel_size, stride=1,

padding=None, dilation=1, groups=1, padding_mode='zeros', bias=False, block_size=32, KDSBias=False, CDS=False):

padding = _pair(autopad(kernel_size, padding))

kernel_size = _pair(kernel_size)

stride = _pair(stride)

dilation = _pair(dilation)

blck_numb = math.ceil(((in_channels)/(block_size*groups)))

super(DSConv, self).__init__(

in_channels, out_channels, kernel_size, stride, padding, dilation,

False, _pair(0), groups, bias, padding_mode)

# KDS weight From Paper

self.intweight = torch.Tensor(out_channels, in_channels, *kernel_size)

self.alpha = torch.Tensor(out_channels, blck_numb, *kernel_size)

# KDS bias From Paper

self.KDSBias = KDSBias

self.CDS = CDS

if KDSBias:

self.KDSb = torch.Tensor(out_channels, blck_numb, *kernel_size)

if CDS:

self.CDSw = torch.Tensor(out_channels)

self.CDSb = torch.Tensor(out_channels)

self.reset_parameters()

def get_weight_res(self):

# Include expansion of alpha and multiplication with weights to include in the convolution layer here

alpha_res = torch.zeros(self.weight.shape).to(self.alpha.device)

# Include KDSBias

if self.KDSBias:

KDSBias_res = torch.zeros(self.weight.shape).to(self.alpha.device)

# Handy definitions:

nmb_blocks = self.alpha.shape[1]

total_depth = self.weight.shape[1]

bs = total_depth//nmb_blocks

llb = total_depth-(nmb_blocks-1)*bs

# Casting the Alpha values as same tensor shape as weight

for i in range(nmb_blocks):

length_blk = llb if i==nmb_blocks-1 else bs

shp = self.alpha.shape # Notice this is the same shape for the bias as well

to_repeat=self.alpha[:, i, ...].view(shp[0],1,shp[2],shp[3]).clone()

repeated = to_repeat.expand(shp[0], length_blk, shp[2], shp[3]).clone()

alpha_res[:, i*bs:(i*bs+length_blk), ...] = repeated.clone()

if self.KDSBias:

to_repeat = self.KDSb[:, i, ...].view(shp[0], 1, shp[2], shp[3]).clone()

repeated = to_repeat.expand(shp[0], length_blk, shp[2], shp[3]).clone()

KDSBias_res[:, i*bs:(i*bs+length_blk), ...] = repeated.clone()

if self.CDS:

to_repeat = self.CDSw.view(-1, 1, 1, 1)

repeated = to_repeat.expand_as(self.weight)

print(repeated.shape)

# Element-wise multiplication of alpha and weight

weight_res = torch.mul(alpha_res, self.weight)

if self.KDSBias:

weight_res = torch.add(weight_res, KDSBias_res)

return weight_res

def forward(self, input):

# Get resulting weight

#weight_res = self.get_weight_res()

# Returning convolution

return F.conv2d(input, self.weight, self.bias,

self.stride, self.padding, self.dilation,

self.groups)

class DSConv2D(Conv):

def __init__(self, inc, ouc, k=1, s=1, p=None, g=1, act=True):

super().__init__(inc, ouc, k, s, p, g, act)

self.conv = DSConv(inc, ouc, k, s, p, g)