开学第一周论文阅读总结

本周阅读了两篇英文文献,第一篇是陈铿的一种基于自适应特征调整的室内场景三维点云多目标检测方法,另一篇是林在超的一种基于特征增强的改进点云补全方法。

目录

- 开学第一周论文阅读总结

- 基于自适应特征调整的室内场景三维点云多目标检测方法

- 论文研究背景

- 论文方法

- 论文的创新点

- 1.自适应特征调整模块(Affinity from Attention)

- 2.CBAM注意力机制

- 论文总结

- 基于特征增强的改进点云补全方法

- 论文研究背景

- 该方向相关工作

- 论文方法

- 论文创新点

- 1.在DGCNN网络中加入SE模块

- 2.使用Transformer自注意力机制重建点云

- 3.在transformer模块中使用轴注意力机制

- 论文结论

- 本周小结

基于自适应特征调整的室内场景三维点云多目标检测方法

论文研究背景

论文的研究背景是在当前时代2D图像的深度学习技术已经逐渐趋于成熟,随着技术的不断发展,目前的研究热题由二维目标的识别升级为对三维目标的识别。近年来,三维目标识别技术被广泛应用于生产机器人、移动目标跟踪、障碍物检测、无人车等多个领域。特别是在室内服务机器人、增强现实等室内场景中,3D目标检测被广泛应用。与室外场景不同,探测室内物体最常见的应用是“采集和转移”任务,这是服务机器人的主要功能。在这些场景中,机器人不仅需要识别周围的物体来找到目标,还需要获取必要的三维目标信息(目标位置、目标尺寸、目标姿态等),使机器人更好地了解室内环境,从而对周围的区域进行语义标记和分类。因此,有必要提高目标检测方法的准确性。本文提出了一种室内场景的多目标检测方法,为室内机器人的发展提供技术支持。

由于直接使用三维图像进行目标识别计算量过大,因此在对三维目标进行目标识别时通常将图像数据转化为点云数据进行模型的训练和识别。

论文方法

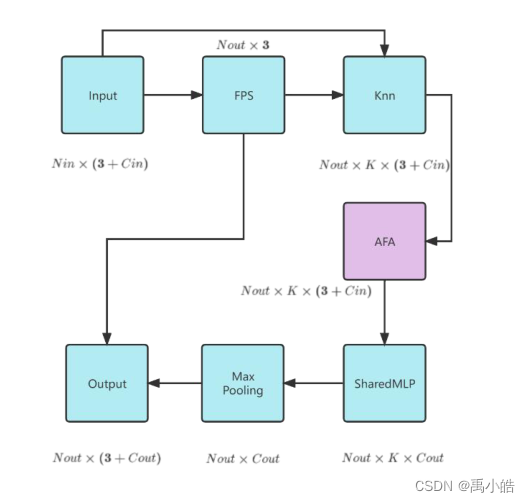

本文提出了一种基于Votenet的三维物体目标检测方法,首先通过骨干模块提取特征,并在其中的SA层开发一个自适应特征调整模块,从而使得邻域上下文的信息融合到点特征中,提高了模型对局部特征的描述能力。然后使用Hough投票,将得到的投票结果进行回归并分类。最后在投票和Preposals模块中加入cbam注意力机制,融合模型的通道注意力和空间注意力,使得模型可以更加关注重要的特征从而忽略不重要的特征,可是使得网络的表达能力得到进一步的提升。最后,在ScanNetV2和SunRGB-D数据集上进行实验,将生成的结果可视化,并与VoteNet的结果进行对比。

论文的创新点

1.自适应特征调整模块(Affinity from Attention)

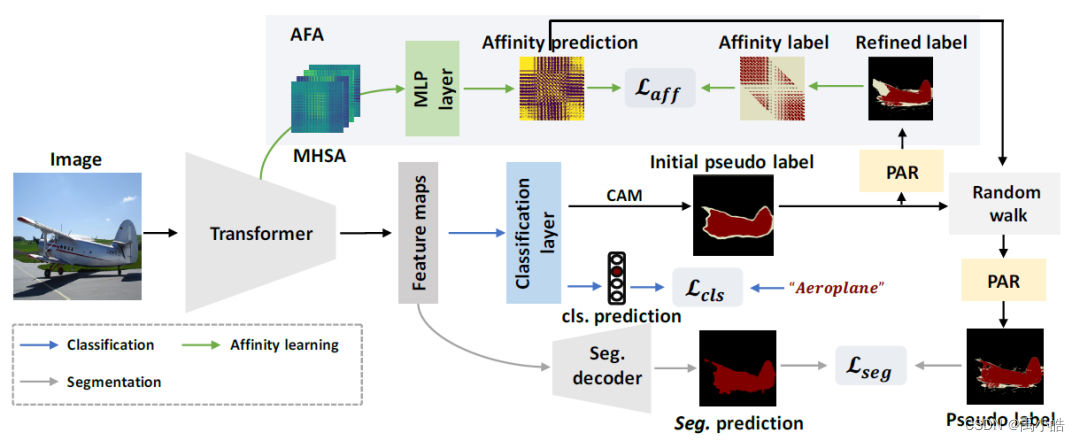

这是在CVPR2022年由武大和京东提出的使用Transformer的端到端弱监督语义分割。

如图3所示,本文使用Transformer作为基础编码器。初始伪标签由CAM方法生成,然后使用提出的像素自适应细化模块(PAR)进行修正。在affinity学习模块(AFA)中,从Transformer中的多头自注意力(MHSA)生成语义affinity预测。AFA使用基于细化初始伪标签的伪affinity标签进行监督。然后,利用学习到的affinity通过随机游走方法对初始伪标签进行改善。在经过PAR的进一步修正后,作为分割分支的监督信息。

这是摘抄别人博客的,论文里面对应的是3.3.2小节说明了这个模块,但是目前自己看不懂。

改进后的模型SA层的结构

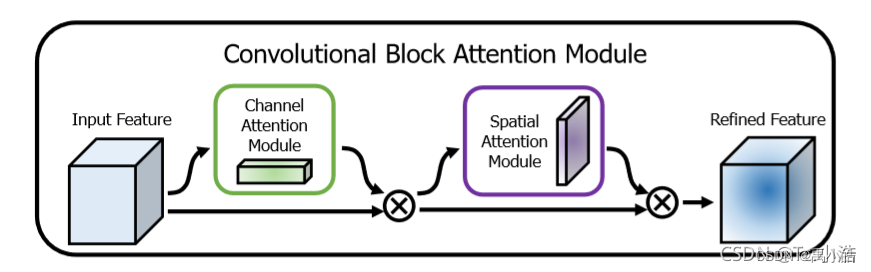

2.CBAM注意力机制

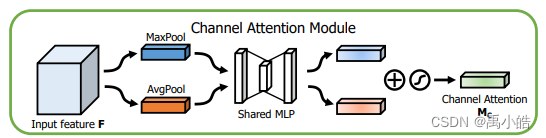

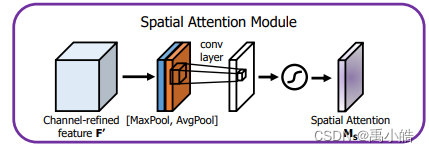

CBAM注意力机制的结构看起来比较简单,主要是先通过通道注意力机制然后再通过空间注意力机制来得到最终结果。

Cbam通道空间注意力机制模块,其中通道注意力模块是为了解决找到物体是什么,通道注意模块是将特征图分别通过最大值池化和平均值池化得到两个新的特征图后,将这两个特征图通过一个双层的MLP并进行相加,最后通过sigmod函数生成最终的通道注意特征。将最终特征和输入特征图进行相乘。生成空间注意力模块需要的输入特征。

Cbam空间注意力机制是为了解决物体在哪里,模块同样经过平均和最大池化层后,将两幅特征图进行拼接之后使用一个7×7的卷积核对其进行卷积运算得到最后结果。

论文总结

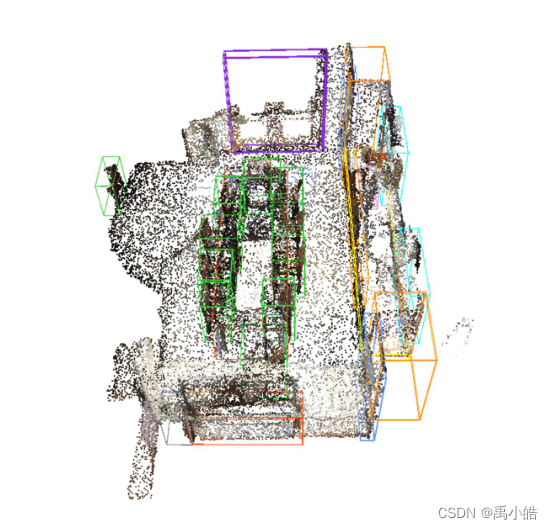

本文首先对于点云数据将其转化为npy文件,以及对于其中的某些点进行删除将原本的密集矩阵转化为稀疏矩阵。然后将其输入到改进后的votenet模型中进行训练,在votenet的SA层中增加了AFA自适应特征调整模块,后续包括介绍的hough投票以及模型的损失函数都是使用votenet模型中的,接着在votenet模型之后加入了cbam注意力机制模块,最后通过NMS非极大值抑制对结果进行优化后进行可视化展示。

可视化展示图

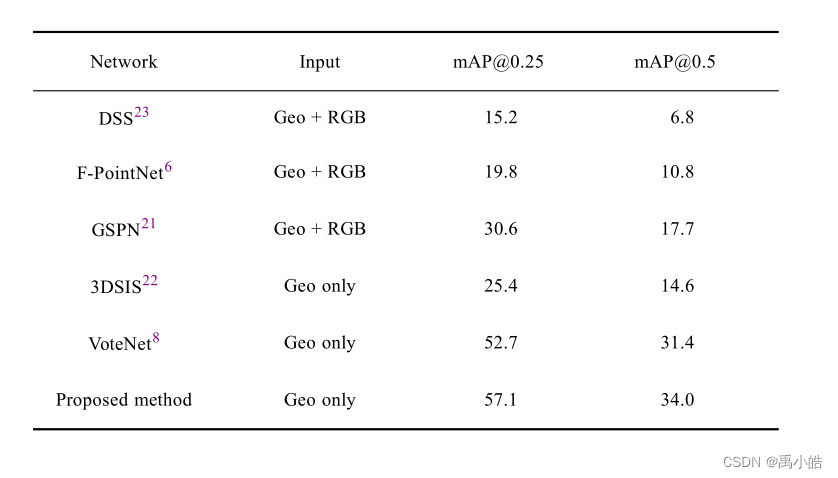

在ScanNetv2数据 上和不同模型对比结果。

从本文中学到的思路,在深度学习模型中对模型进行改进时,第一步可以在骨干模块上添加部分提取特征的模块进行优化改进。第二步可以在模型后加上注意力机制模块,基本的se以及本文使用的cbam模块

基于特征增强的改进点云补全方法

论文研究背景

随着计算机图形技术在各个领域(电子游戏、制造业、医疗模拟等)的发展,对复杂3D模型的使用需求越来越大。然而,3D模型通常有大量的信息和复杂的格式,这需要技术知识和建模经验来处理。相比之下,点云只包含点信息,快速、准确、易于访问和存储,成为近年来的研究热点。然而,在使用深度相机采集点云数据时,由于环境干扰、物体遮挡、操作不当等原因,采集到的原始点云往往不完整。因此,点云补全成为一个新兴的研究方向,其目标是将不完整的点云变成完整的点云,以便用于研究或工业。

该方向相关工作

1.Yuan提出了一种叫做PCN的方法,使用编码解码的结构,采用FoldingNet将二维点映射到三维点曲面上形成了一种点云补全的方法。

2.Huang等人提出了一种多级损失函数神经网络模型,通过学习全局特征来填补确实区域,实现了从不完整点云到完整点云的映射。

3.Peng等人提出了一种基于非学习的网络SDME-net,该方法可以不完整甚至有噪声的点云数据上实现从稀疏到稠密的转换,无需任何变换。

4.Yu等人提出了Pointr网络,该网络引入了一个几何敏感的变压器模块,将点云表示为一组无序的点代理,并使用编码器-解码器的结构来填补缺失部分。

论文方法

本文提出了一种基于porintr网络的点云补齐方法,通过DGCNN网络增强局部特征,扩大transformer的接收域。本文主要分为三个步骤,首先采用最远点样本从原本数据中取得一组中心点,然后利用多层感知机从这些中心点的局部位置进行嵌入,经过加入SE模块改进后的DGCNN网络。然后将增强后的点代理输入Transformer模块进行编码解码的结构重建点云。最后通过FlodingNet网络进行最后的点偏移计算,从而实现补全点云。

论文创新点

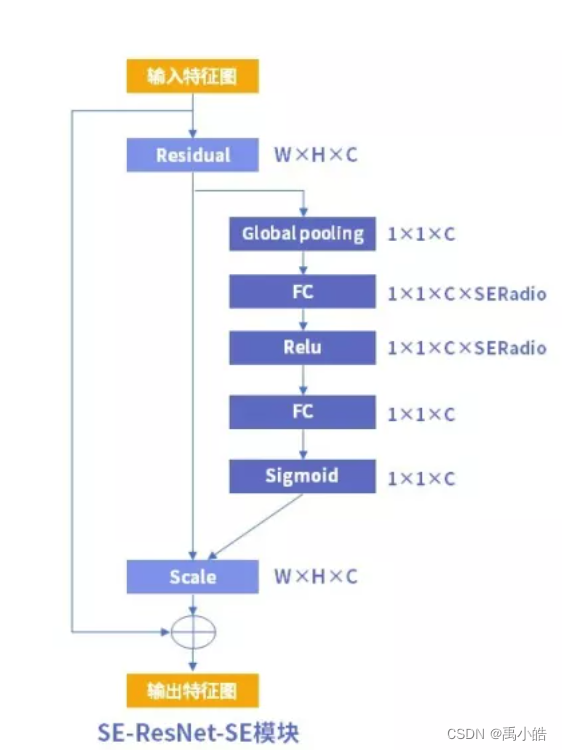

1.在DGCNN网络中加入SE模块

Senet模块就是注意力机制中的SE模块,模块的结构比较简单,由一个全局池化层加两层的FC加sigmod函数以及scale层输出。好处是不会增加很多的参数量,但是可以对性能有些许提升。

2.使用Transformer自注意力机制重建点云

Transform模块是经常使用在自然语言处理中的一种模块,模型的核心是一种编码加解码的结构。也叫作自注意力机制。

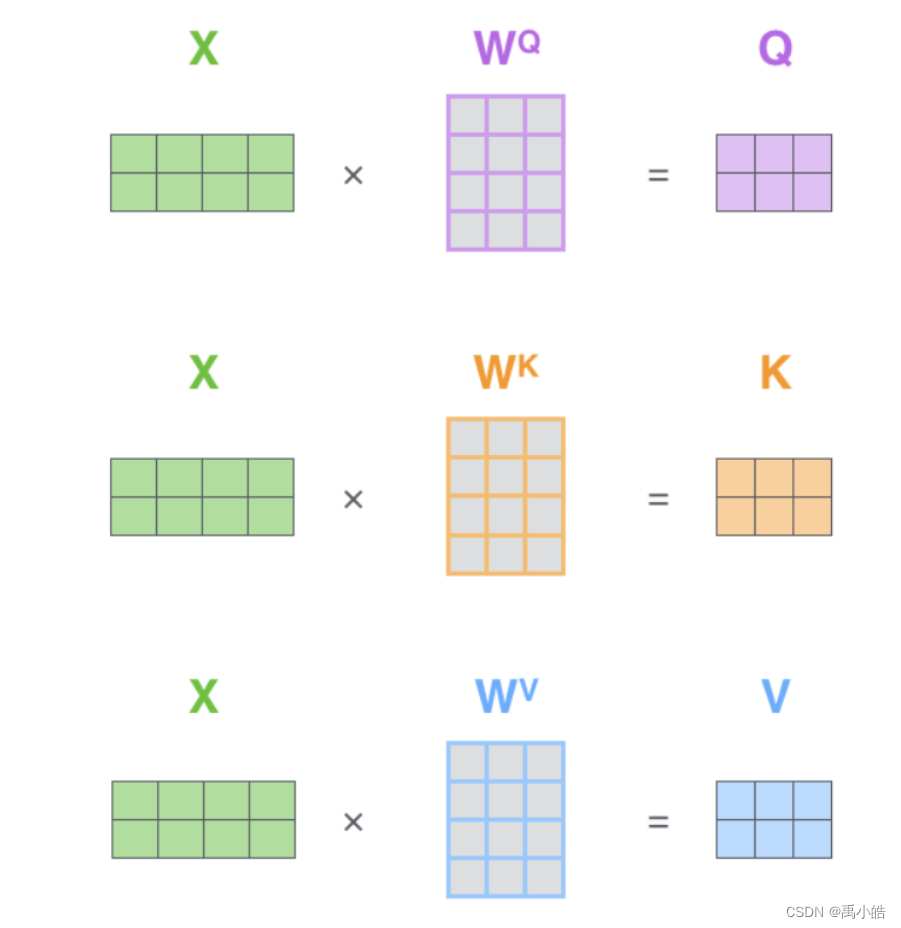

编码结构:简单来说就是将输入的每个单词转化为词向量的形式,首先需要生成三个向量,通过词嵌入得到的三个向量和三个权重矩阵相乘得到查询向量、键向量、值向量。

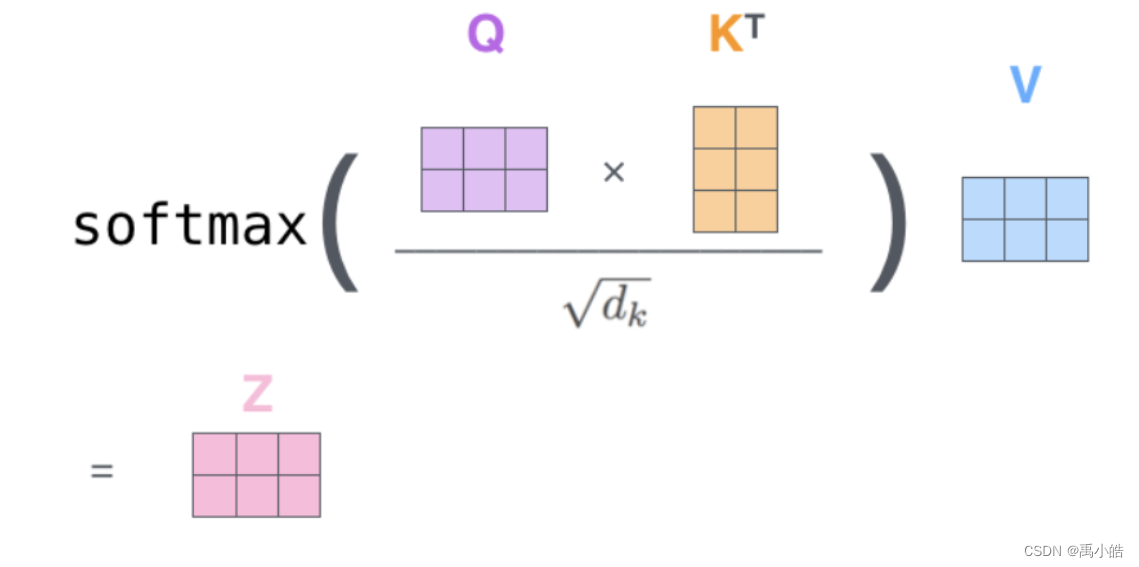

然后通过将所有输入句子的键向量和所计算单词的查询向量点积得到每个单词对所计算单词的分数,将分数除以8后通过softmax层进行归一化,最后将每个输入句子单词的的值向量和softmax层的结果进行乘积得到编码层的结果。

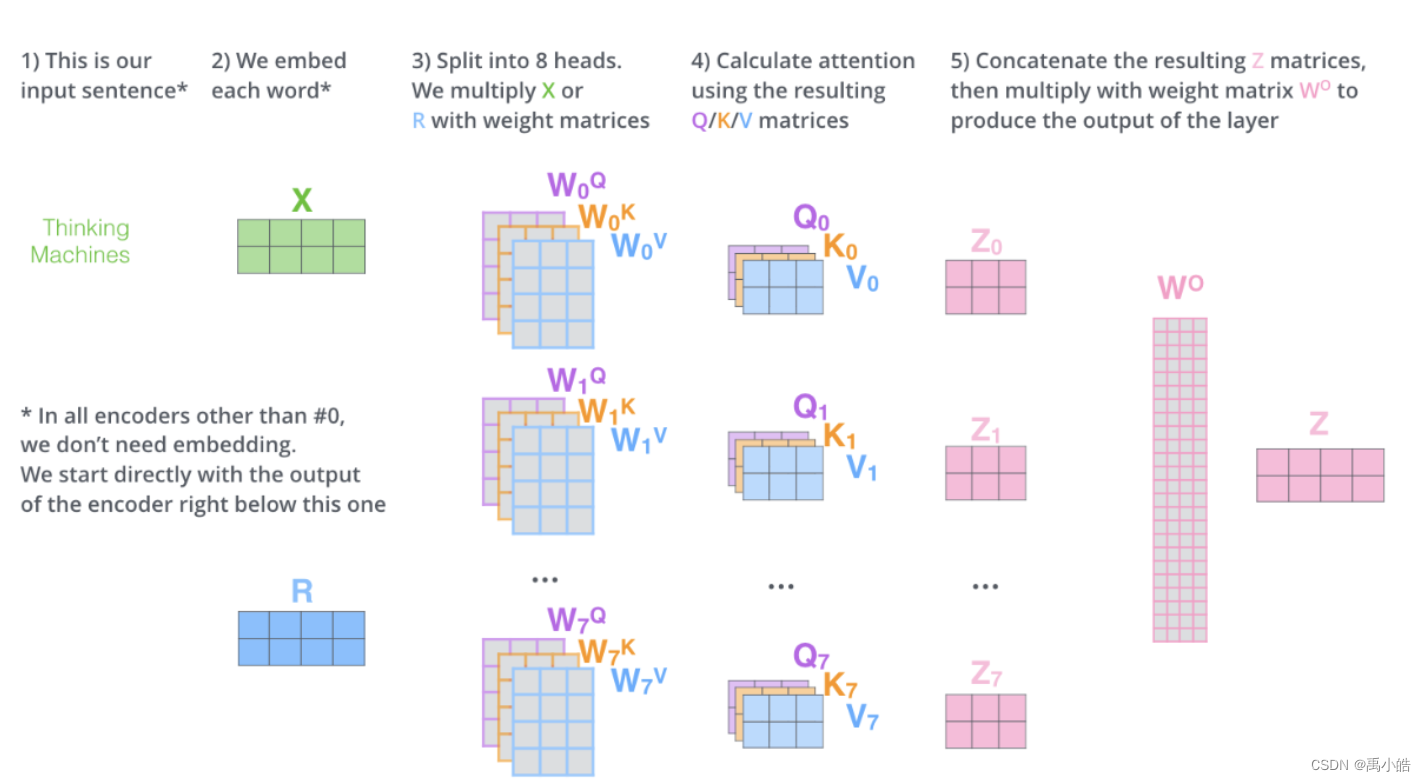

为了扩展模型专注于不同位置的能力,引入了多头的机制,即在使用权重矩阵对词嵌入进行相乘时使用8个权重矩阵分别进行相乘并得到8个结果。将得到的8个结果进行拼接以后,对其再乘以一个权重矩阵,最后同样通过softmax层得到最后结果。同时为了体现每个单词在句子中的位置信息,引入了一个位置编码向量来代表单词在句子中的信息。

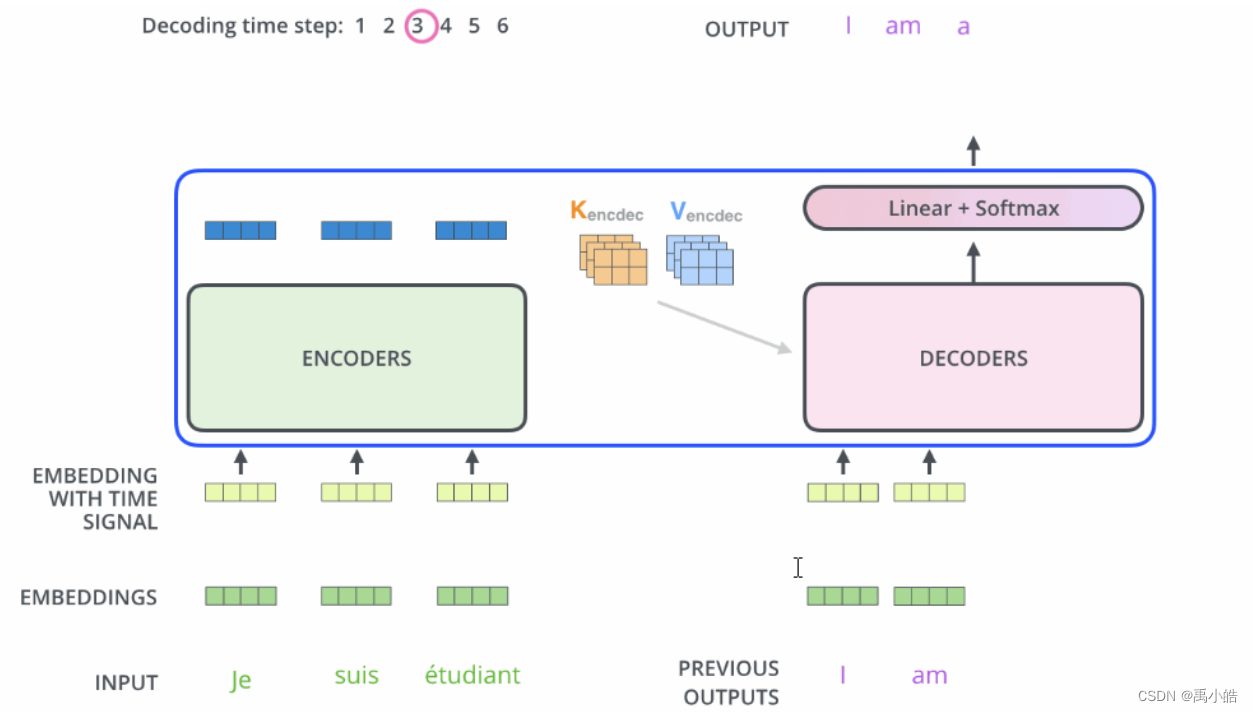

解码过程:将上文得到的信息重新解码成三个向量,并加入残差模块和位置编码模块来确定单词的位置,最后通过一个线性的softmax层完成映射。

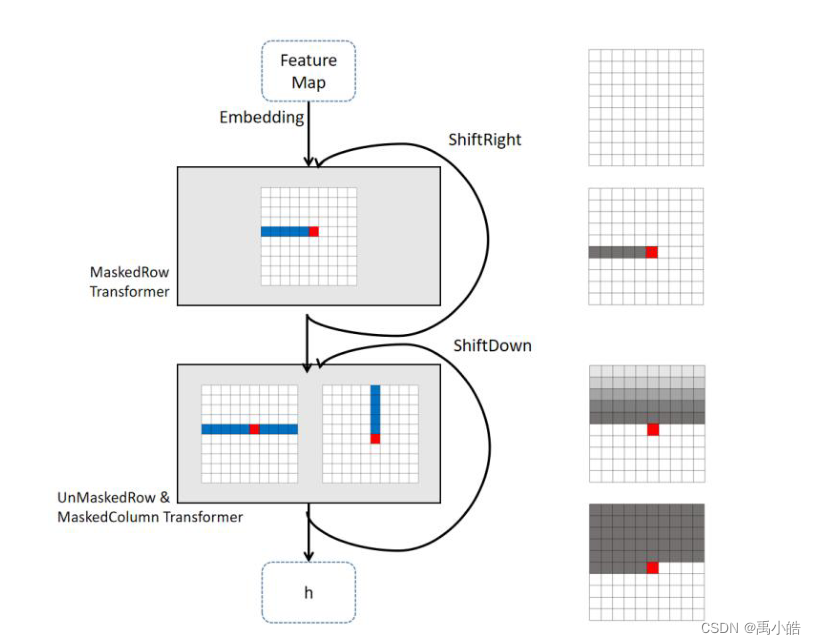

3.在transformer模块中使用轴注意力机制

具体变换如下图所示,没有看懂,以后有需要再回来研究。

如果要在图像中引用Transformer注意力机制,就必须把不管是三维的还是二维的图像转化为一维的向量。同时由于图像会导致计算量剧增,这也说明了本文为什么要采用点代理的方法。如果在2维图像中使用transformer会由于二维图像的原因导致计算量剧增。那么如果先在竖直方面进行self-attention然后在水平方面进行self-attention就可以使计算量大大减少,提高模型的计算效率。

论文结论

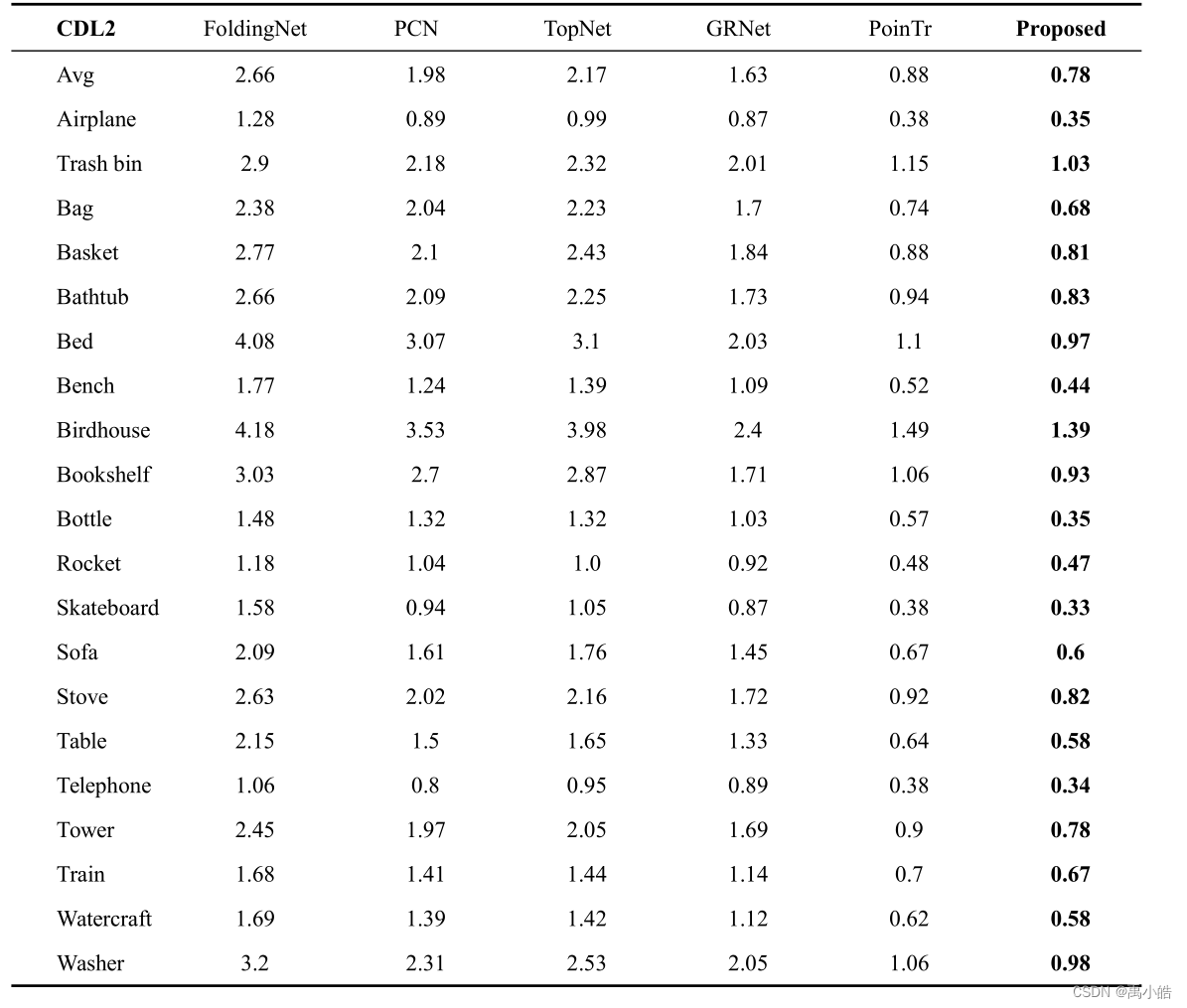

在ShapeNet55数据集上可以看出性能相较于其他模型有较大的提高

本文的阅读感受,第一次知道可以在利用模型对点云数据进行补齐,这点有点类似于之前自己做机器学习的时候可以利用模型去填补一些缺失值。本文的思路也很新奇,贯穿全文的是利用注意力机制来对缺失的点云数据进行补全,在图像中使用自注意力机制会带来巨大的计算量,那么为了减少计算量以及提升计算效率。本文先使用了增加SE模块的DGCNN模型来实现对局部特征的提取,然后将提取后的点代表输入改进后的axise-attention模块中进行训练预测,为什么使用axisl-attention的原因也是为了减少计算量。最后通过transformer层的数据输入flodingnet模型中进行最后的细致预测,从而实现了点云补齐。

本周小结

在深度学习中,贯穿到底的一条线是数据,特征,模型三个部分。那么像写作文一样如何把自己的作品不断进行丰满也是主要围绕这三个部分进行

本周阅读的两篇论文中,第一篇基于3D点云数据进行预测的,主要是对特征和模型两个方面进行丰满,在提取特征这方面上,对votenet的SA层进行了进一步的改进,添加了AFA自适应特征提取模块,同时在votenet模型后面加入了cbam注意力机制使得模型的性能能够进一步的提升。这使得整篇文章的内容更加丰满。

第二篇林在超的论文着重点则在数据和特征上,决定一个模型上限的永远是数据,这篇文章围绕如何填补点云数据,首先利用增加了SE模块注意力机制的DGCNN网络对原始数据进行特征提取,得到点代表后使用transformer模块进行点预测,同时改进transformer模块使其成为轴注意力机制,最后将transformer预测后的粗点云数据再经过flodingnet网络进行细预测从而实现点云补全。这篇文章给我的启发是如果在深度学习中引入了trnsformer模块那么一定要注意计算量的问题。

这两篇文章收获非常大,让我能够了解3D点云数据的目前研究现状以及创新点,也为我进一步学习深度学习打下基础。